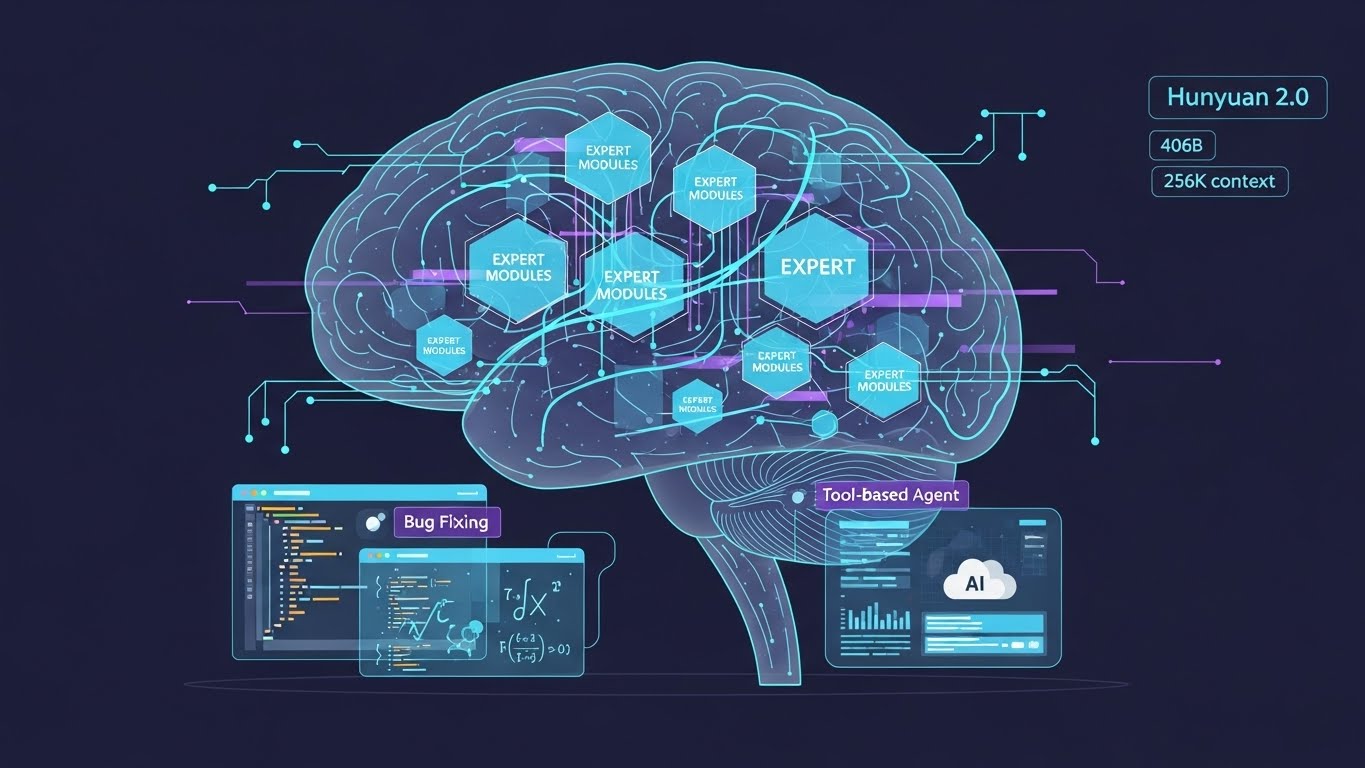

2025年12月5日,騰訊發布了自主研發的大規模語言模式「混元2.0(騰訊HY2.0)」。 HY2.0採用混合專家(MoE)架構,總參數數為406B,啟動參數數為32B,上下文視窗大小為256K。

與前代產品混源-T1-20250822相比,改進後的版本HY2.0Think修改了預訓練資料和強化學習策略,在數學、科學、程式碼和指令遵循等複雜推理任務中,展現了國內一流的性能和泛化能力。

在數學和科學領域,透過大規模部署強化學習,推理能力得到了顯著提升,並在IMO-AnswerBench、HMMT2025、Humanity's Last Exam (HLE) 和ARC AGI等基準測試中取得了優異成績。此外,採用重要性取樣校正的長視窗強化學習提高了長文本多輪指令追蹤和任務執行的穩定性。

在程式碼和代理能力方面,可驗證環境和高品質合成資料的開發提高了代理編碼和工具呼叫任務的實際效能,提高了 SWE-bench Verified 和 Tau2-Bench 等真實世界基準測試的得分。

HY2.0 和 DeepSeek V3.2 已嵌入騰訊的 AI 原生應用程式(如元寶和 ima)中,也作為 API 和平台服務在騰訊雲端上提供。

從: ![]() 騰訊自主研發的大模型混源2.0發布:多面向顯著提升

騰訊自主研發的大模型混源2.0發布:多面向顯著提升

【社論】

騰訊的混元2.0不只是另一個大規模的LLM(邏輯學習模型),它標誌著「推理」和「智能體」這兩個維度終於進入了可以實際應用的階段。尤其是在數學和科學基準測試、SWE-bench Verified和Tau2-Bench等任務中取得的優異成績,可以被視為從聊天機器人向「問題解決型智能體」轉變正在加速發展的標誌。

256K 個情境的長度使得在載入規範、整個儲存庫和完整的內部知識集後,由 AI 進行審查並提出修改建議成為現實。當與長窗口強化學習和智能體框架結合使用時,「人構思整體,AI 組裝並執行具體步驟」的角色劃分在許多領域都將變得可行。

同時,將如此強大的模型、強大的推理能力和智能體功能與龐大的使用者群體結合所帶來的風險不容忽視。這是因為,創建針對行為歷史進行優化的、具有說服力的智能體,並透過生成的內容巧妙地引導用戶價值觀,將變得前所未有的容易。隨著模型功能的日益強大,關於透明度、日誌可驗證性以及人類治理設計的問題也將層出不窮。

這則新聞將人們的注意力從膚淺的「中國法學碩士競賽」轉移到諸如如何分解工作以及人類應該在決策過程中保留多少控制權等設計問題上。在各種工程和商業環境中,決定哪些工作應該交給人工智慧,哪些工作不該交給人工智慧,很可能成為未來幾年至關重要的主題。

[術語]

專家混合小組(教育部)

這是一種模型結構,它將多個子模型(專家)捆綁在一起,並且對於每個輸入只運行部分專家,從而在降低計算成本的同時增加參數總數。

256K 上下文視窗<br>這是一個輸入長度,一次可以處理大約 256,000 個標記的文本,這意味著它可以載入和處理整個文件或程式碼庫。

強化學習(RL)

這是一種機器學習方法,其中模型透過反覆試驗來學習策略以最大化獎勵,並在 LLM 中用於提高推理的一致性和指令遵循能力。

大規模推廣

這是一個通用術語,指的是強化學習方法,該方法涉及讓模型產生長推理鏈,並評估過程和提供回饋,適用於數學和科學中的多階段推理任務。

SWE-bench / SWE-bench 已驗證

這是一個基準測試,用於衡量 LLM 使用來自真實 GitHub 儲存庫的問題和錯誤修復任務來自動化軟體工程任務的能力。

Tau2-Bench (𝜏²-Bench)是一個用於評估代理的基準,模擬涉及工具調用和外部系統整合的技術支援操作,旨在衡量多工具、多步驟能力。

人類的最後考試(HLE)

這是一套旨在全面評估廣泛的常識和推理能力的測試套件,可作為衡量法學碩士知識水平和概括能力的指標。

ARC AGI

此測試評估抽像模式識別和推理能力,是一項基準測試,要求具備高度靈活的推理技能,而不是簡單地將推理技能應用於現有數據。

[參考連結]

騰訊(外部)

它是一家總部位於中國深圳的大型科技公司,業務範圍廣泛,包括社交媒體、遊戲、金融科技和雲端運算。

騰訊混源(外部)

在騰訊大規模人工智慧模型集團的官方網站上,您可以找到語言、多模態模型和基於雲端的人工智慧服務的概覽。

騰訊雲(外部)

它是一個雲端平台,提供基礎設施、資料庫、人工智慧等,並允許用戶使用各種人工智慧服務,包括混元系列和DeepSeek相容的API。

DeepSeek (外部)

這是一家開發大規模語言模型的中國公司,它以開放生態系統的形式發布了 DeepSeek V3.2 等模型,並致力於將這些模型整合到其他公司的雲端服務和應用程式中。

SWE-bench (外部)

這是一個發布基準測試和排行榜的網站,用於評估LLM在開源程式庫中修復bug的開發技能。

Tau2-Bench (外部)

此基準測試基於工具的使用情況來評估人工智慧代理的操作能力,並允許使用者查看各種模型的分數和任務概覽。

[參考文章]

騰訊HY 2.0:教育部模型,IMO推理73.4 (外在)

這是一篇解釋性文章,提供了有關 HY 2.0 的 MoE 結構、406B 參數、256K 上下文以及 IMO-AnswerBench 和 SWE-bench Verified 的分數等技術要點的詳細資訊。

騰訊雲DeepSeek OpenAI API (外部)

DeepSeek 相容 API 的官方文件透過可用模型、端點和定價結構,深入介紹了混源的雙管齊下策略。

𝜏²-Bench 電信基準排行榜(外部)

在 Tau2-Bench 上可以查看每個模型的分數和評估標準,這有助於將基於代理的模型與其他模型的工具利用能力進行比較。

[編者註]

隨著混元2.0等模型的出現,「我們應該把多少工作交給AI?」這個問題突然變得更加現實。在你的工作中,你希望先將哪些任務交給AI,例如修復bug、整理文件或撰寫研究備忘錄?

我很樂意繼續與您合作,闡明具體的用例,並逐步確認「未來的工作模式」。