人腦是如何「理解」語言的?

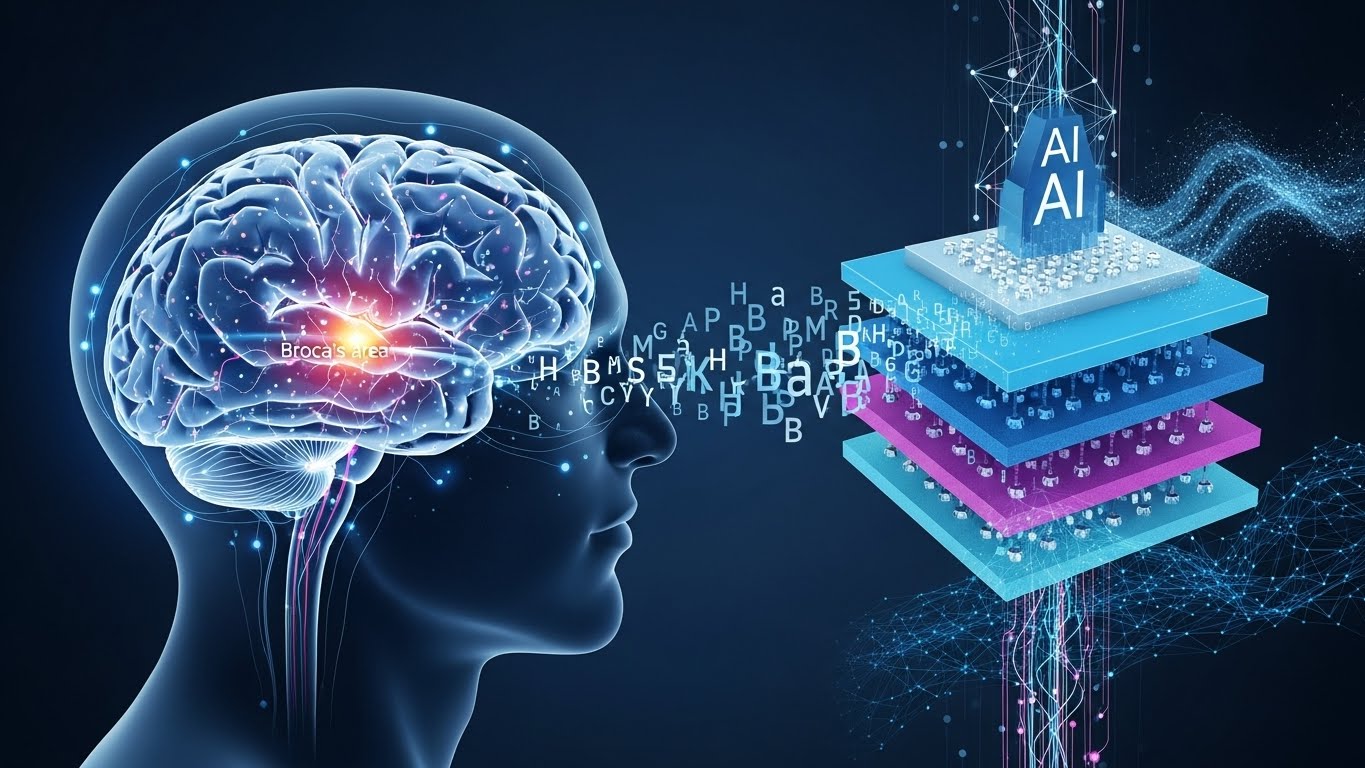

耶路撒冷希伯來大學發表的最新研究表明,這個過程可能與 GPT-2 和 Llama 2 等大型語言模型的內部結構驚人地相似。大腦在聆聽口語時的活動在時間上與人工智慧分解文字和添加上下文的層級相對應,這一事實悄然動搖了「人工智慧與人類完全不同」的直覺。

隨著我們與生成式人工智慧的互動成為日常生活的一部分,大腦與人工智慧之間究竟發生了什麼事?這項研究或許能為我們重新定義這一界限提供契機。

由耶路撒冷希伯來大學的 Ariel Goldstein 博士領導的研究團隊,與谷歌研究院的 Mariano Schain 博士、普林斯頓大學的 Uri Hasson 教授和 Eric Ham 合作,發現人腦處理口語的方式與人工智慧語言模型分析文本的方式之間存在驚人的相似之處。

這項研究於2025年11月26日發表在《自然通訊》雜誌上,研究人員收集了參與者收聽30分鐘播客時的腦電圖資料。結果表明,GPT-2和Llama 2等大型語言模型的層級結構與大腦中語言處理的時間線相吻合。

「人工智慧模型的深層結構與後續的大腦反應相對應,尤其是在布羅卡區等高級語言區域。這一發現挑戰了以往關於語言理解依賴於符號規則和僵化的語言層級的理論,並支持一種基於語境的、動態的和統計的方法。”

研究團隊已將完整的神經記錄資料集與語言特徵相結合,並公開發布,使世界各地的科學家能夠檢驗關於人類語言理解的各種理論。

從: ![]() 你的大腦理解語言的方式可能比我們想像的更像人工智慧。

你的大腦理解語言的方式可能比我們想像的更像人工智慧。

【社論】

這項研究的意義遠不止於發現大腦和人工智慧的相似之處。更重要的是,它表明我們需要從根本上重新思考我們幾十年來一直信奉的語言理解模型。

傳統語言學認為,人腦透過組合語法規則、音素和語素等符號元素來理解語言。然而,這項研究表明,人工智慧生成的上下文嵌入比這些經典的語言特徵更能準確地預測即時大腦活動。

尤其值得注意的是處理過程的一致性:人工智慧模型的早期層追蹤簡單的詞語特徵,而更深層的層則整合上下文和含義。大腦也遵循完全相同的模式,早期神經反應對應於人工智慧模型的早期層,後期反應對應於更深層的人工智慧模型。在布羅卡區觀察到了顯著的相關性,隨著人工智慧模型層數的增加,大腦的峰值反應出現得更晚。

這項發現表明,語言理解並非基於固定的規則,而是根據脈絡動態建構意義的過程。這意味著,自生成式人工智慧出現以來我們所看到的那些透過統計方法從海量資料中學習模式的機制,本質上與人類大腦經過數百萬年進化而來的方法類似。

更重要的是,研究團隊已將神經記錄資料完全公開,使世界各地的研究人員能夠使用同一資料集來檢驗假設,進一步模糊了神經科學和人工智慧研究之間的界線。這些發現也可能直接有助於開發更忠實地模擬人類認知的下一代人工智慧模型。

然而,這項研究也引發了倫理問題。人工智慧越接近模仿人類的思考過程,就越需要進行更根本的辯論,例如,將人工智慧的產物稱為「理解」是否恰當,以及它們與人類創造力有何不同。隨著大腦和人工智慧的融合,或許我們應該重新思考科技與人類之間的關係。

[術語]

腦電皮層圖(ECoG)

這項技術是將電極直接放置在大腦表面以記錄神經活動。它比非侵入性腦電圖(EEG)具有更高的空間和時間分辨率,能夠捕捉諸如語言處理等詳細的腦活動。由於它主要用於外科手術過程中,因此數據收集的機會有限。

大型語言模型(LLM)

一種能夠從海量文字資料中學習,並根據上下文生成和理解自然語言的人工智慧模型。典型的例子包括GPT和Llama,它們由多層構成,每一層處理不同層次的語言特徵。

上下文嵌入

這是一種將詞語和短語置於高維向量空間中的表示方法。同一個字可以根據上下文擁有不同的向量嵌入,從而能夠捕捉語義的多樣性。這項技術是人工智慧模型「理解」語言的基礎。

布羅卡區

這個位於大腦額葉的區域參與語言處理。人們一直認為它主要負責語言產生和語法處理,但最近的研究表明,它也與語言理解密切相關。

音素和語素

音素是語言中最小的聲音單位,語素是最小的意義單位。傳統語言學一直認為這些符號元素是語言理解的基礎,但這項研究表明,人工智慧的上下文表徵能夠更好地解釋大腦活動。

[參考連結]

自然通訊-原始論文(外部連結)

一篇經過同行評審的原創論文,詳細闡述了大腦時間語言處理與人工智慧語言模型層級結構之間的對應關係。

耶路撒冷希伯來大學(外在)

這項研究的負責人阿里爾‧戈德斯坦博士任職於以色列的一所綜合性研究型大學。

谷歌研究院(外部)

合著者馬裡亞諾·沙因博士是Google研發部門的成員。

普林斯頓大學(外部連結)

這是一個全球認知神經科學研究中心,Uri Hasson教授和Eric Ham教授都隸屬於該中心。

EurekAlert! (外部)

由美國科學促進會營運的科學新聞稿發布平台

[參考文章]

大腦利用類似人工智慧的計算進行語言處理——神經科學新聞(外部連結)

在 30 分鐘的播客收聽過程中,大腦活動與 GPT-2 和 Llama 2 的時間序列處理層級相符。

人腦中自然語言處理的時間結構-自然(外在)

完整的原始論文包括電極放置、音頻刺激以及 GPT-2 與 Llama 2 每一層之間的相關性分析的完整描述。

希伯來大學研究揭示我們的大腦處理語言的方式可能與聊天機器人類似——CFHU (外部)

演講中引用了 Ariel Goldstein 博士的評論,強調了大腦和人工智慧之間逐漸理解過程的融合。

[編者註]

每當你與人工智慧對話時,你是否曾想過「它真的理解我的意思嗎?」這項研究為此問題提供了一個新的視角。研究發現,我們大腦理解語言的過程與人工智慧的處理結構驚人地相似,這促使我們重新思考科技與人類之間的界線。

如果語言──人類最主要的能力──實際上是一個統計性的、依賴語境的過程,那麼創造力和意識的本質是什麼?你如何解釋這種趨同現象?